Executando Modelos Localmente com Ollama - Parte 1

Com Ollama, a inteligência artificial está ao seu alcance, trazendo poder e privacidade para suas mãos.

Nos últimos anos, a demanda por inteligência artificial e modelos de linguagem tem crescido exponencialmente.

Com isso, surge a necessidade de executar esses modelos localmente, garantindo maior controle e privacidade dos dados. Uma ferramenta que tem ganhado destaque nesse cenário é o Ollama.

Neste post, vamos explorar como executar modelos de linguagem localmente usando o Ollama e suas principais vantagens.

O que é Ollama?

Ollama é uma plataforma que permite executar modelos de aprendizado de máquina localmente de maneira simples e eficiente.

Com uma interface intuitiva, essa ferramenta facilita o acesso a modelos pré-treinados e permite que os desenvolvedores implementem suas próprias soluções de IA sem depender de serviços na nuvem.

Vantagens de Executar Modelos Localmente

Privacidade: Ao executar modelos localmente, você mantém o controle total sobre seus dados, importante quando lidamos com informações sensíveis.

Baixa Latência: Modelos executados localmente têm tempos de resposta mais rápidos (em teoria rsrs), uma vez que não dependem de chamadas à nuvem.

Custo-Efetividade: Dependendo do uso, a execução local pode ser mais econômica do que pagar por chamadas a APIs em nuvem.

Como Começar com Ollama

É realmente muito simples e fácil executar modelos com Ollama. Para começar a usar, siga os passos abaixo:

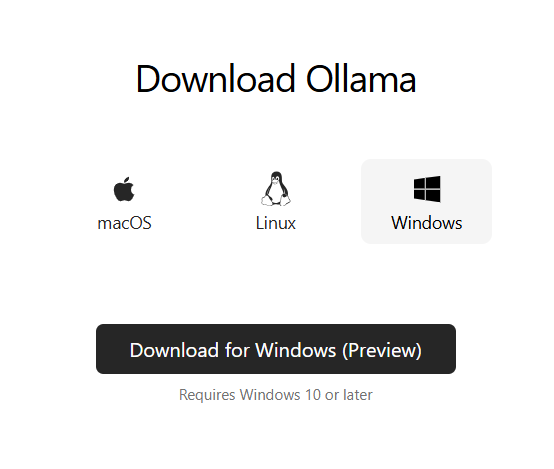

1. Instalação do Ollama

Primeiro, você precisa instalar o Ollama em sua máquina. Você pode fazer isso através do terminal com o seguinte comando:

curl -sSfL https://ollama.com/download | shOu fazendo download do instalar direto pelo site https://ollama.com:

Siga as instruções do instalador. No Windows, após a instalação a aplicação irá aparecer na barra de ferramentas do lado direito na parte inferior da tela. Quando você ver esse ícone, saberá que o Ollama está executando em seu computador, pronto para ser utilizado.

2. Baixando um Modelo

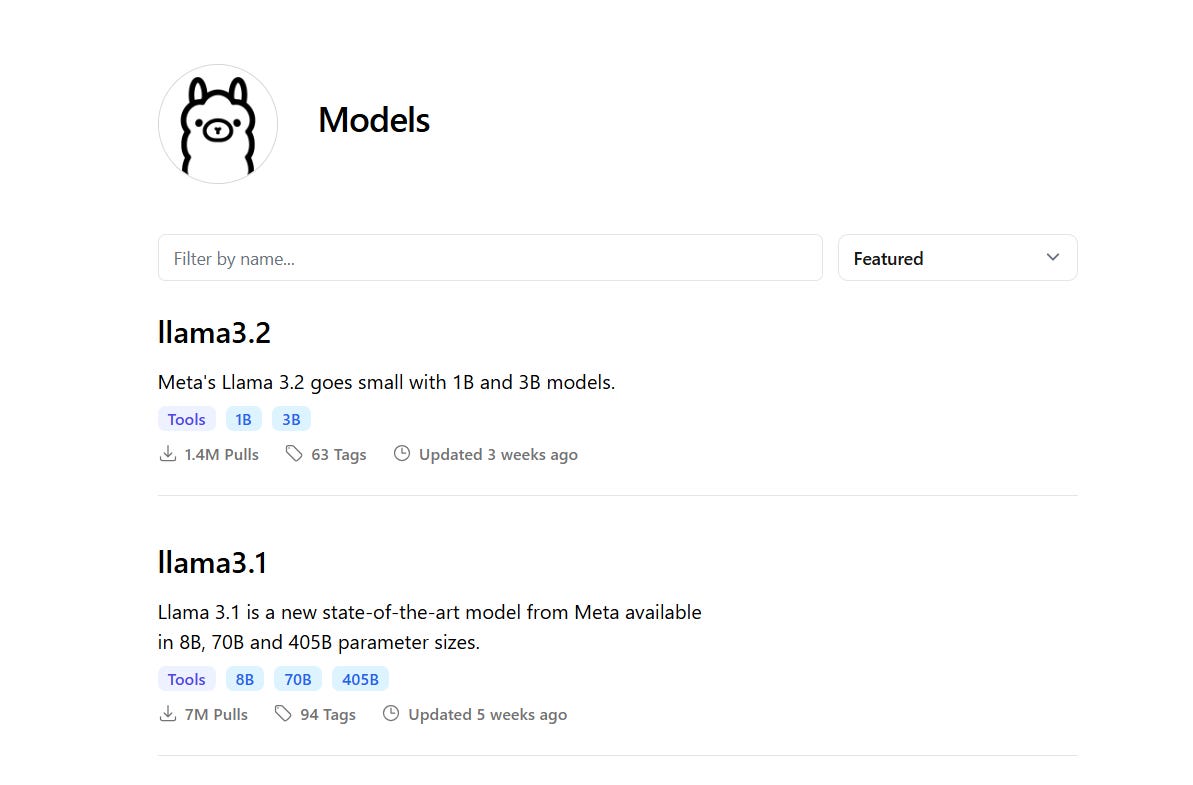

Após a instalação, você pode baixar um modelo pré-treinado. Por exemplo, para baixar o modelo llama3.2, execute no terminal ou cmd do Windows:

ollama run llama3.2Os modelos da família Llama 3.2, da Meta, são modelos de linguagem multilíngues disponíveis em tamanhos de 1B e 3B de parâmetros, super leves e fáceis de executar até em seu notebook.

No site você consegue ver os modelos disponíveis, clicnado em Models:

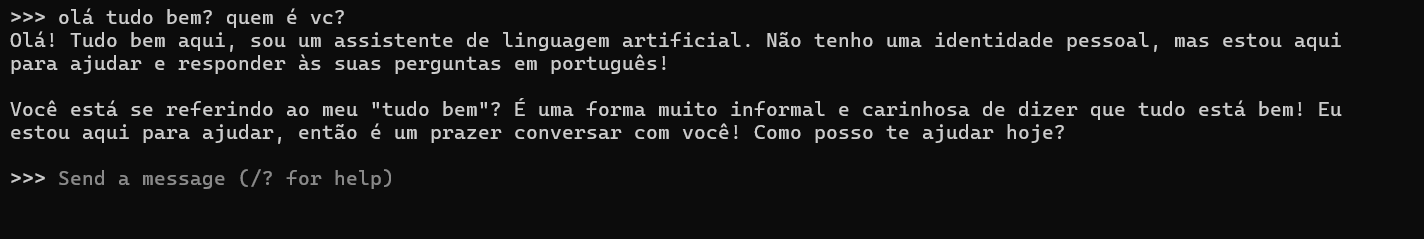

3. Executando o Modelo

Uma vez que o modelo estiver baixado, você pode executá-lo (inferência) usando o seguinte comando:

ollama run llama3.2O Ollama irá processar a sua entrada e fornecer uma resposta em tempo real, e aguardar a próxima interação.

Pronto! Você já está conversando com seu LLM no seu próprio computador! 👏

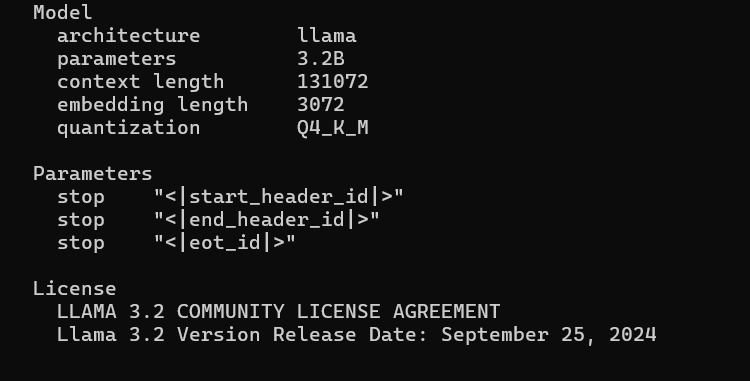

4. Detalhes do Modelo

Para ver mais detalhes do modelo, basta executar esse comando:

ollama show llama3.2Você vai ser os detalhes do modelo, como número de parâmetros, quantização, licença, etc.

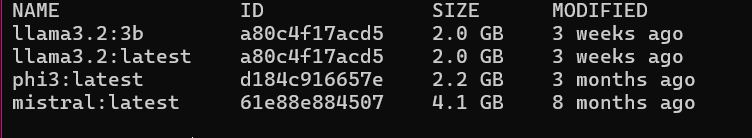

5. Listando os seus Modelos

Para ver todos os modelos que você já baixou, execute esse comando:

ollama listEsse comando irá listar todos os modelos disponíveis na sua máquina. Isso é importante porque os modelos podem ocupar muito espaço no seu disco!

Fim da primeira parte

Executar modelos localmente com Ollama é uma excelente maneira de aproveitar o poder da inteligência artificial enquanto mantém a privacidade e a eficiência.

Com sua instalação simples e variedade de modelos disponíveis, é uma ferramenta valiosa para desenvolvedores e empresas que buscam inovação em suas soluções.

No próximo post, vamos criar uma aplicação de chatbot usando o Ollama com Docker.

Aguarde!! 🩷